首先说的是业界上周最出圈的谷歌AI模型Gemini 3

在核心性能上,Gemini 3 Pro预览版以1501分登顶LMArena排行榜,在WebDev Arena测试中以1487分大幅领先GPT-5近100分,其72.7%的屏幕截图理解能力更是当前最先进水平的两倍,为Agent赋予了接近人类的“视觉智能”。

达子说:“我们为谷歌的成功感到高兴——他们在人工智能领域取得了巨大进展,我们将继续向谷歌供货。英伟达领先行业一代——它是唯一能够在所有计算场景下运行所有AI模型的平台。与为特定AI框架或功能设计的ASICs相比,英伟达提供了更优越的性能、通用性和灵活性。”

很快就被打脸了,Meta开始不稳,有点暧昧goole的迹象。

据The Information报道,Meta正在与谷歌洽谈,计划从2027年开始,斥资数十亿美元购买 Alphabet 旗下公司的芯片,用于其数据中心。

也许Meta和谷歌的谈判,其实是试图压低英伟达的利润率。

Meta真正想要谷歌的TPU吗?还真不好说,我们等着看。

谷歌刚刚使用自家的 Ironwood TPU 完成了 Gemini 3.0 的训练。

此前普遍认为 TPU 的主要优势在于推理,而训练仍然需要英伟达 GPU。

但是,谷歌宣布Gemini的训练完全使用Ironwood TPU完成。

以建造一个英伟达数据中心的成本来建五倍数量的TPU数据中心

另外,谷歌也有可能聘请博通和台积电来设计和制造自己的定制 AI ASIC,从而绕过英伟达。

OpenAI/Oracle还得去去买子弹,孰优孰劣一看便知。

回到谷歌的Gemini 3,其正式采用了谷歌的 Ironwood TPU SuperPod 。

这个训练推理集群,总共集成了 9,216 个芯片,采用了基于大规模OSC交换机和"3D+1D" Torus 拓扑。

其使用了环面拓扑而非经典的 CLOS 架构,带来了更低的交换机芯片总需求,相较于庞大的 CLOS 交换网络,降低了设备成本和功耗。

Ironwood TPU SuperPod 提供两种规格:256 芯片配置和 9,216 芯片配置。

Ironwood的计算能力扩展至每个pod 9,216个芯片,总算力达到 42.5 Exaflops,是目前全球最大超级计算机 El Capitan 的 24 倍以上——El Capitan 每个 pod 的计算能力仅为 1.7 Exaflops。

我们知道CPU 是计算机的处理单元,相当于计算机的大脑,专为通用编程而设计。而 GPU 则是一种性能加速器,用于增强计算机图形和人工智能工作负载。

TPU 是谷歌自主开发的处理器,它使用 TensorFlow(一种特定的机器学习框架)来加速机器学习工作负载。

TPU (Tensor Processing Units),也是一种专用集成电路 (ASIC)。

在2013 年,谷歌的领导层——特别是 Jeff Dean、Groq 的 CEO Jonathan Ross 以及 Google Brain 团队——进行了一项预测,计算得出,如果每个 Android 用户每天使用谷歌新推出的语音搜索功能仅三分钟,谷歌就需要将其全球数据中心的容量翻一番才能应对由此产生的计算负载。

当时,谷歌依靠的是标准的CPU和GPU来处理这些任务。虽然这些通用芯片性能强大,但对于深度学习所需的特定繁重运算(例如大规模矩阵乘法)来说效率低下。利用现有硬件进行扩展不现实。

这催生了一个新项目。谷歌决定打造自己的定制芯片,目标是创建一个专用ASIC芯片,其唯一用途就是运行TensorFlow神经网络。

2013-2014年:项目进展神速,谷歌组建团队,仅用了15个月就完成了从设计概念到在数据中心部署芯片的整个过程

2015年:在全世界都不知道TPU存在之前,它们就已经在为谷歌的产品提供支撑,加速着谷歌地图导航、谷歌照片和谷歌翻译。

2016 年:谷歌在 2016 年Google I/O 大会上正式发布了TPU

共封装光器件 (CPO) 设计通过将光引擎更靠近交换芯片来提供帮助。

但 OCS 更进一步,在结构层级上实现机架和电路板上的全光交换——中间没有任何转换层。

据半导体分析公司 SemiAnalysis 称,谷歌定制的 OCS 网络使其整体网络吞吐量提高了 30%,功耗降低了 40%,数据流完成时间缩短了 10%,网络停机时间减少了 50 倍,资本支出降低了 30%。

TPU和光学器件的这种紧密结合定义了新的“Google Stack”——一种围绕 AI 核心工作负载设计的计算基础架构。

其核心原理是在光域内直接进行光信号的交换,从而彻底无需传统电交换机的光-电-光转换环节。这一特性带来了超低延迟和超高带宽的网络连接。

OCS器件本质上是光交叉连接器。它们具有多个输入和输出光纤端口,可以动态地将任意输入连接到任意输出,形成连续的光路。它们对信号速度和信号上承载的协议并不敏感。

OCS 内部使用了一些常见的技术,用于将光从一个端口物理切换到另一个端口。微机电系统( MEMS)反射镜,液晶开关,压电光束偏转。

由于OCS交换机将数据保存在光域中,因此它们对数据速率和格式基本透明。无论信号速率是10 Gbps、100 Gbps还是800 Gbps,光交换机都不需要了解其具体参数,只需要转发光信号即可,所以这些交换机能够处理巨大的带宽。

OCS 交换机几乎没有延迟,信号损耗也非常小。本质上,它就像在设备之间直接铺设了一根光纤,但可以通过软件重新连接。

基于OCS的网络通过省去许多光电转换和ASIC交换级,可以显著提高能效。在某些情况下,它们可以将网络设备的功耗降低近70%。

例如,谷歌的Palomar OCS交换机功耗约为108W。其中大部分功耗用于保持和控制微镜。

另外,我们也可以看见在谷歌的 TPU 集群架构中,上层的 Spine 交换机采用全光化 OCS 方案,而下层的 Leaf 交换机和 TOR 交换机仍使用传统电交换方式 —— 这正是因为下层网络端口间流量切换频繁,传统的交换机的灵活性更适配,而上层网络流量相对稳定,OCS 的优势能充分发挥。

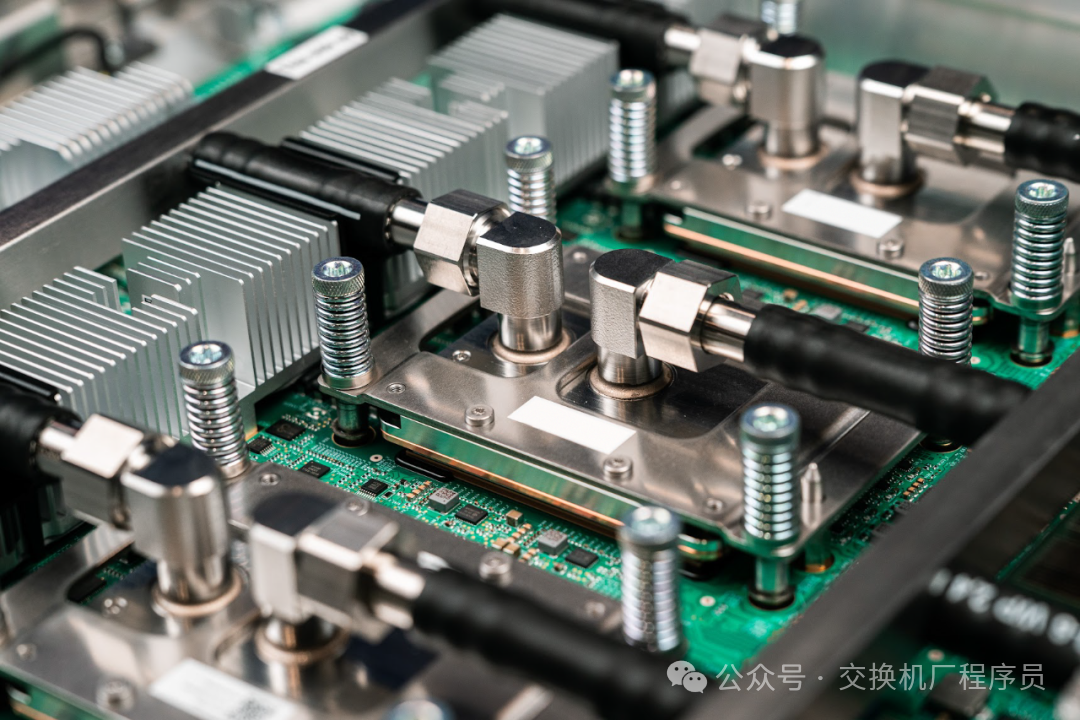

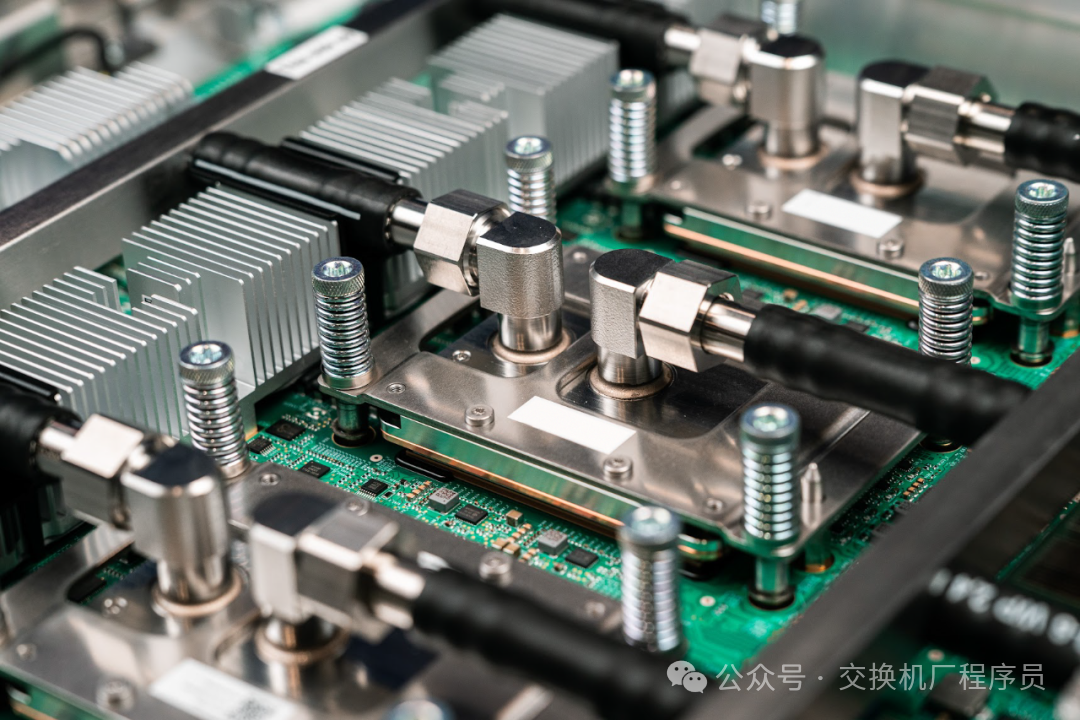

例如,从 TPU v4 开始,谷歌就全面引入 OCS 技术,每个机架包含 16 块板卡(每块板卡有 4 个 TPU 芯片),总计 64 个 TPU;64 个机架组成一个集群(共 4096 个 TPU),通过 48 台 OCS 交换机实现跨机架互联,每台 OCS 交换机提供 128 个端口。最新的 TPU v7(Ironwood)集群,单个集群已能连接多达 9216 颗 TPU 芯片,通过OCS交换机实现互联,单集群带宽达到 1.6Tbps。

市场方面,每100万颗TPU对应OCS约1.2万台。

如果明年TPUv7出货400万颗,保有量达到 500万颗,OCS 适配比例提升至 70%,对应的 OCS 需求量将达到 500 万 ×1.2%×70%=4.2 万台。

谷歌其OCS 采购量就预计将从 2024 年的 1.2万台 增至 2026 年的 4.2万台,市场规模将增长至 18-20 亿美元,

目前市面上有很多端口数在 500 及以上的商用光交换机。

在这种情况下,如果NVIDIA 工作负载或 CUDA 工作负载,可以直接迁移到 Microsoft Azure,获取一台配备 NVIDIA GPU 的虚拟机,无需任何代码更改,即可直接运行。

英伟达的CUDA技术早已深入大多数人工智能工程师的脑海,占领先机

谷歌的生态系统主要在内部构建,而对外则相对封闭,迄今为止,它只将TPU用于内部工作负载。

而业界则倾向于CUDA和PyTorch(尽管TPU现在也支持PyTorch)。

虽然谷歌正努力使其生态系统与其他技术栈更好地兼容和转换,但这仍然需要大量的库和生态系统建设,而这需要数年时间。

大多数客户采用多云环境也给 TPU 的普及带来了挑战,因为 AI 工作负载与数据及其位置密切相关(云数据传输成本高昂)。Nvidia 显卡可通过三大超大规模云服务商访问,而 TPU 目前仅在 GCP 上可用。

很明显,在短期内,NVIDIA 仍然牢牢掌控着以 GPU 为中心的 AI 计算生态系统,其领导地位在短期内没有挑战者。从长远来看,人工智能基础设施的竞争可能并非赢家通吃。制的ASIC芯片(例如谷歌的TPU)和通用GPU(例如英伟达的GPU)可能会发展成为互补的、针对特定任务的结构。根据工作负载类型、成本状况和性能优化目标,它们各自可以满足不同的需求。

发表评论 取消回复